本プロジェクトは、Pioneroが大規模データシステム(Big Data)構築において持つ技術力と戦略的なアプローチを体現した取り組みです。 私たちは、日本語に特化した大規模かつ多様なデータセットを生成することを目的に、複雑なWebクローリングシステムを開発しました。 このシステムにより収集されたデータは、日本語および日本文化に対する深い理解を持つ次世代の大規模言語モデル(LLM)のトレーニングに向けた堅牢な基盤となっています。

概要

参照URL

非表示

ジャンル

大規模データ収集(Large-Scale Data Crawling)、AI / 機械学習システム、ビッグデータ基盤、バックエンド開発

クライアント

非表示

開発期間、規模

6ヶ月、24人月

開発体制

TL1名、BrSE1名、SE3名

担当範囲

UIデザイン、基本設計、Webアプリ/デスクトップアプリの開発およびテスト

技術スタック

React.js

FastAPI

Python

Selenium

AWSなど

備考

大規模データ収集基盤

メイン機能

機能説明

日本語特化最適化

漢字、ひらがな、カタカナなどの日本語文字セットを的確に識別・処理できるよう、システムを最適化。

Unicodeの正規化を自動で行い、日本語以外のデータを除外することで、データセットの一貫性と純度を確保。

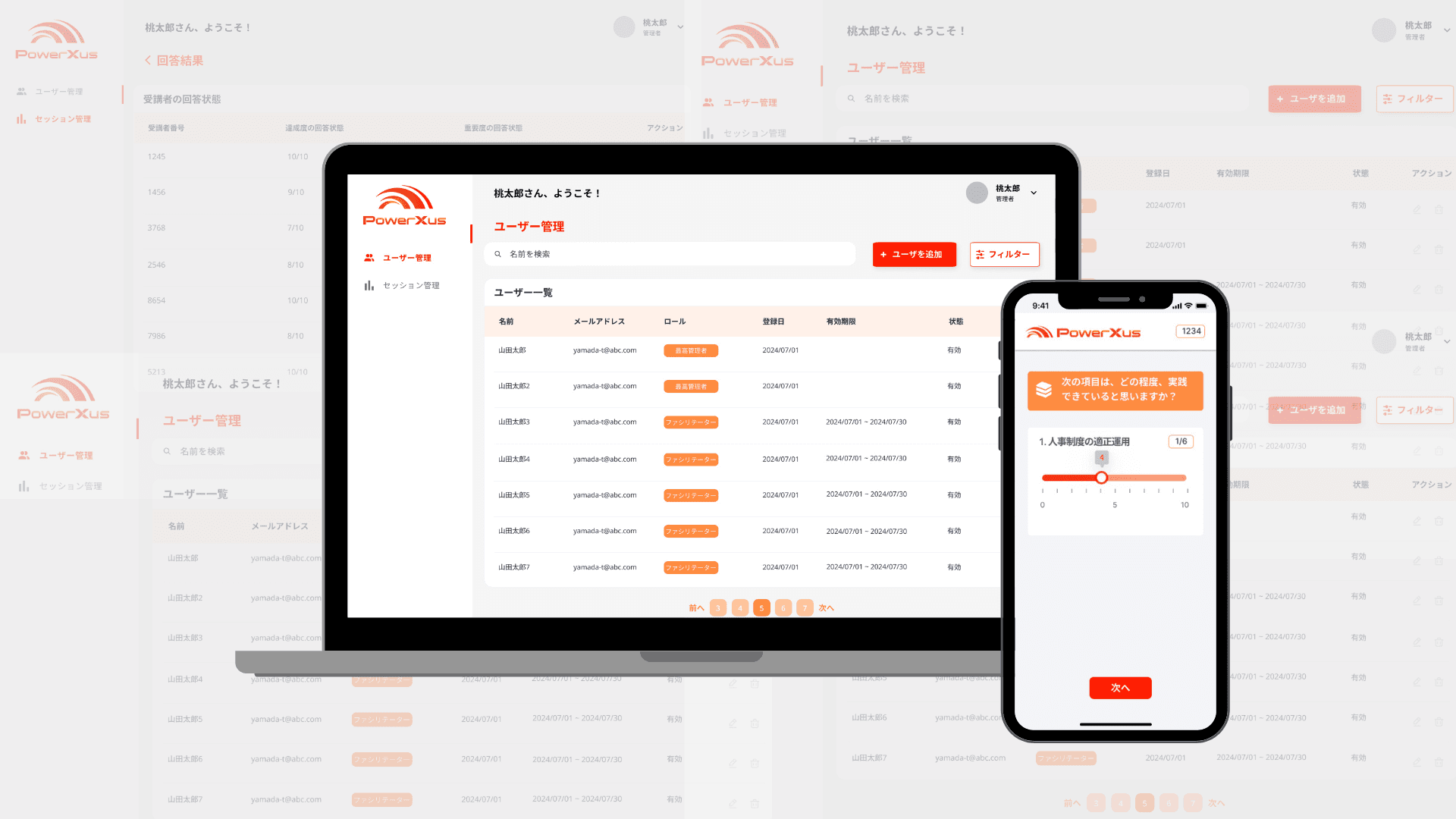

クローリングの監視・可視化

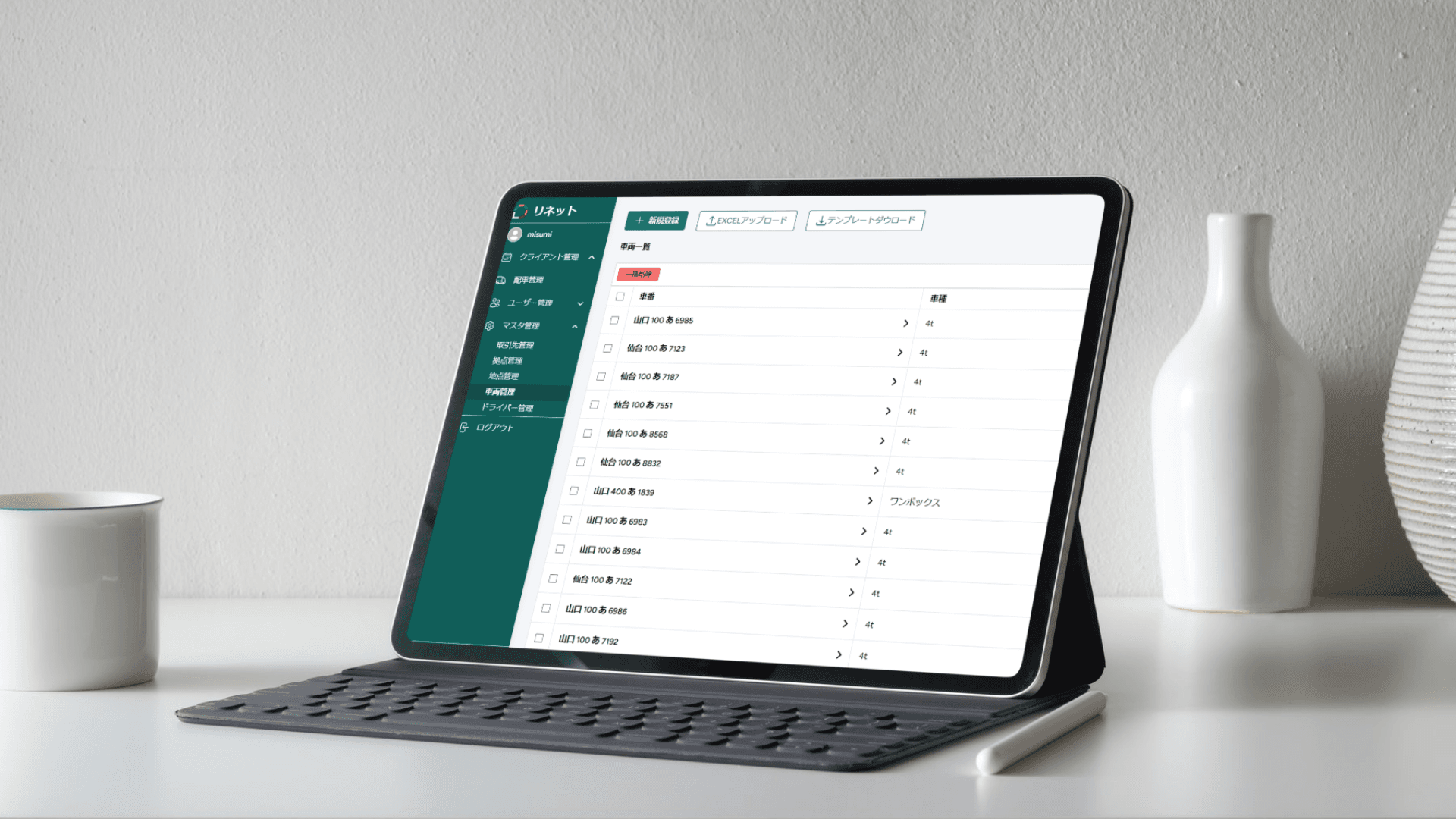

React.jsベースのダッシュボードを構築し、クローリングの進行状況やドメイン別データ量、リアルタイムのエラーレートを可視化。

HTTPエラー、パースエラー、エンコーディングエラーなどの詳細ログを提供し、運用チームによる迅速なデバッグとパフォーマンス最適化を支援。

多様なソースターゲティング

システムは拡張性を重視して設計されており、Yahooニュース、Yahoo知恵袋、NHK、おしえて.jpなど、日本の主要で信頼性の高い複数のドメインからのデータ収集が可能。

マルチフォーマットデータ収集

テキスト、画像、オーディオブックなど、複数の形式のデータを自動で収集。

自然言語処理(NLP)を活用し、主要コンテンツの抽出(コンテンツエクストラクション)および関連メタデータ(タイトル、説明、公開日など)を取得。

Seleniumを統合し、Lazy-LoadingやJavaScriptレンダリングを必要とする動的なWebページにも対応。

重複排除・データクレンジング

重複コンテンツを自動的に検出・排除するアルゴリズムを統合。

ノイズやスパムデータを除去するフィルタリング機能を備え、高品質なコンテンツを優先的に保持。

大規模データ収集基盤

共有